Как закрыть сайт от индексации в robots.txt — 3 основных способа

В каких случаях может понадобиться закрыть поисковым роботам доступ к сайту и как это сделать.

-

10+

стаж работы в

интернет маркетинге -

103

написано тематических

статей

Случаев, когда нужно закрыть сайт от индексации в Яндексе и Google много. Например, вы обновляете дизайн и не хотите, чтобы пользователи видели страницы сайта, пока он ещё не готов. Или вам нужно скрыть какую-то служебную информацию, которая не должна попасть в открытый доступ. Это могут быть пароли, клиентские личные данные, технические моменты и т.д. Помимо того, что это, скорее всего, приведёт к неприятным последствиям для репутации компании, это может негативно повлиять ещё и на успех SEO-продвижения. Ведь поисковые роботы любят, когда пользователям доступен только самый полезный и уникальный, а не служебный контент.

Чтобы такого не произошло, давайте разберём основные способы, с помощью которых можно остановить индексацию всего ресурса или какой-то части его контента.

Закрыть сайт от индексации через robots.txt

Этот файл все поисковые роботы оценивают перед тем, как начать собирать информацию о ресурсе. Задача у него одна — он отвечает за запрет или разрешение индексации. Поэтому логично, что начинаем мы именно с этого способа.

Найти robots.txt можно в корневом каталоге ресурса. Если его там нет, можно создать документ в формате txt в любом текстовом редакторе и вручную добавить его в нужную папку.

Чтобы поисковики могли увидеть ваш файл, он должен быть:

- Не больше 500 кб по размеру;

- Создан в формате txt и называться robots.txt;

- Расположен в корневой папке;

- Доступен для роботов. То есть ответ сервера при запросе к странице, где он размещён, должен быть 200 ОК.

Без этого поисковая система не увидит или не сможет прочитать документ, а значит весь сайт автоматически будет доступен для индексирования, и все ваши настройки не будут работать.

Вот что можно сделать с помощью этого файла:

Закрыть весь сайт

Для этого нужно удалить все строки и оставить только две:

User-agent:*

Disallow:/

Читается это так: первая строчка — обращение к поисковым роботам. Звёздочка означает, что информация ниже предназначена для всех. Вторая строка означает запрет индексации. И так как там не указано, что конкретно мы запрещаем индексировать, то действие распространяется на весь контент ресурса.

Закрыть от индексации отдельную папку или файл

Это требуется делать гораздо чаще. Ведь очень часто бывает, что вы планируете продвигать ресурс в поисковой выдаче, но при этом не хотите, чтобы туда попали отдельные виды его контента.

Чтобы закрыть отдельную папку, нужно просто прописать её название. Выглядеть это будет так:

User-agent:*

Disallow:/admin/

Если понадобилось скрыть несколько папок, просто пропишите ниже директивы disallow для каждой.

Для файлов всё то же самое. Только в директиве disallow прописываем путь до них. Например:

User-agent:*

Disallow:/admin/passwords.txt

Чтобы закрыть папку, но при этом разрешить доступ к отдельному файлу в ней, директивы allow и disallow можно использовать вместе:

User-agent:*

Allow:/admin/passwords.txt

Disallow:/admin/

Скрыть от Google

Если вы не хотите, чтобы какой-то контент показывался в Google, можно установить ботам этой поисковой системы запрет на индексацию сайта. При этом для Яндекса ресурс всё равно останется доступным.

Чтобы это сделать, вместо звёздочки в обращении к поисковым роботам указываем конкретный поисковик. Вот как это будет выглядеть:

User-agent: Googlebot

Disallow:/

Обратите внимание, что мы пишем не просто Google, а именно Googlebot. Именно так к поисковику принято обращаться.

Запретить для Яндекса

Здесь действуем по такому же принципу, но обращаемся уже к Яндексу:

User-agent: Yandex

Disallow:/

Обратите внимание, что на кириллице писать нельзя.

Если вы хотите скрыть сайт от всех поисковых систем, кроме одной (например, Яндекса), то директива будет выглядеть так:

User-agent: *

Disallow:/

User-agent: Yandex

Allow:/

Закрыть изображения

Если вам нужно скрыть определённый формат картинок, директива будет выглядеть так:

User-agent: *

Disallow:/*.jpg

Вместо формата jpg, может быть любой другой: jpeg, png или gif.

Запретить показ отдельной страницы

Сначала нужно прописать для каких поисковиков действует правило, а потом указать адрес страницы. Причём он указывается без домена. Например:

User-agent: *

Disallow: /catalog/bikes

Закрыть отдельный поддомен

У каждого поддомена должен быть свой robots.txt. Поэтому если вы хотите запретить индексировать весь поддомен, стоит действовать так же, как если бы вы хотели запретить индексацию всего сайта. Заходим в документ или создаём его в корневой папке и прописываем:

User-agent:*

Disallow/

Если на поддомене нужно скрыть файлы, папки, изображения или какой-то ещё отдельный элемент, так же руководствуемся инструкциями выше для каждого случая.

Как проверить, что вам удалось скрыть сайт или отдельные его части?

Это можно сделать с помощью Яндекс.Вебмастера и Google Search Console.

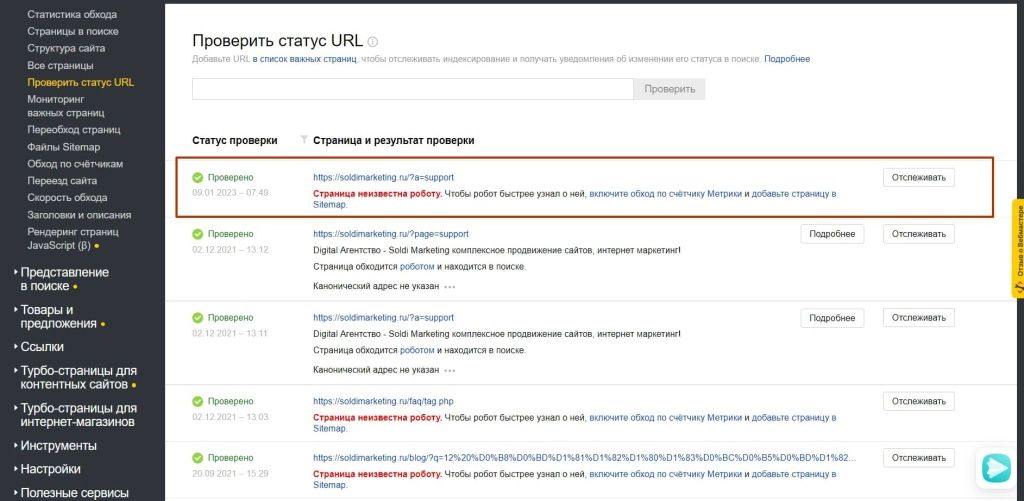

В Вебмастере заходим в “Индексирование”, а потом в “Проверить статус URL”. В поле нужно ввести ссылку на сайт, страницу или другой объект, а потом дождаться окончания проверки и посмотреть отчёт.

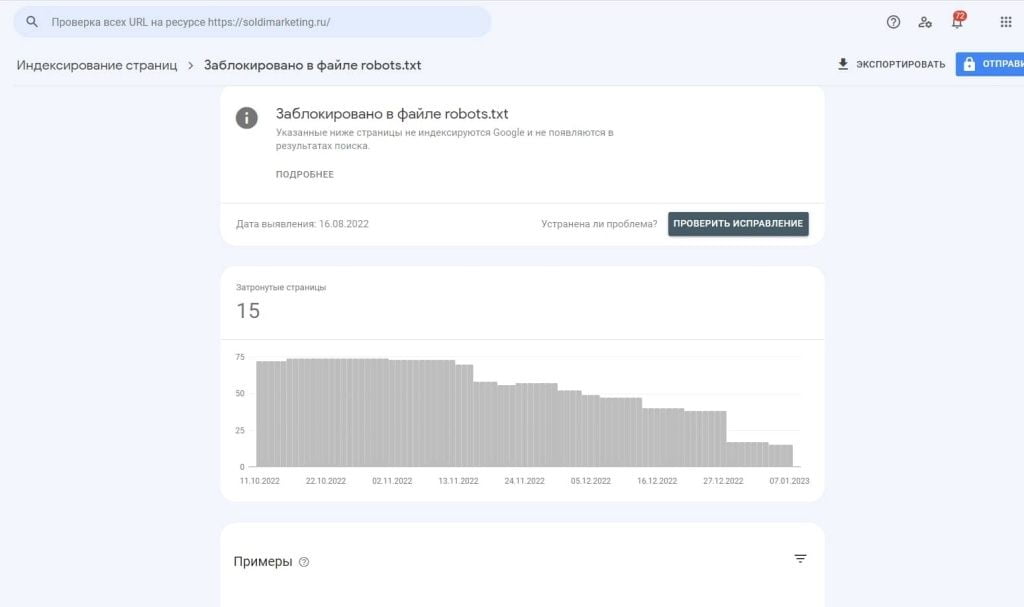

В Search Console заходим в раздел “Индекс,” а затем “Покрытие”. Если объект скрыт от индексирования, там вы увидите ошибку и пояснение, что доступ заблокирован в файле robots.txt.

Проверить доступность ресурса для роботов обязательно стоит. Ведь иногда система может не считать вашу команду. Google особенно часто игнорирует запрет индексации в robots.txt. В их инструкции для веб-мастеров написано, что в некоторых случаях поисковая система может всё равно показывать сайт в выдаче. Например, если на него ссылаются другие ресурсы. Поэтому если инструменты для вебмастеров показали, что сайт всё ещё индексируется, можно использовать другие способы. О них ниже.

Запрет индексации через файл htaccess

Это ещё один файл, который должен находиться в корневой папке ресурсов, работающих на сервере Apache (а это большинство ресурсов). Он даёт возможность управлять работой сервера и влиять на разные настройки сайта. Например, запрещать его индексирование. Для этого там также, как и в robots.txt, можно прописывать разные директивы.

Чтобы скрыть ресурс от всех поисковых роботов, нужно прописать в документе такие строки:

SetEnvIfNoCase User-Agent «^Googlebot» search_bot

SetEnvIfNoCase User-Agent «^Yandex» search_bot

SetEnvIfNoCase User-Agent "^Yahoo" search_bot

SetEnvIfNoCase User-Agent "^Aport" search_bot

SetEnvIfNoCase User-Agent "^BlogPulseLive" search_bot

SetEnvIfNoCase User-Agent "^msnbot" search_bot

SetEnvIfNoCase User-Agent "^Mail" search_bot

SetEnvIfNoCase User-Agent "^spider" search_bot

SetEnvIfNoCase User-Agent "^igdeSpyder" search_bot

SetEnvIfNoCase User-Agent "^Robot" search_bot

SetEnvIfNoCase User-Agent "^php" search_bot

SetEnvIfNoCase User-Agent "^Snapbot" search_bot

SetEnvIfNoCase User-Agent "^WordPress" search_bot

SetEnvIfNoCase User-Agent "^Parser" search_bot

SetEnvIfNoCase User-Agent "^bot" search_bot

Ещё вариант прописать запрет через директиву FilesMatch:

<FilesMatch "\.html$">

Header set X-Robots-Tag "noindex,nofollow"

</FilesMatch>

Таким образом будут скрыты все файлы html формата. Если есть задача исключить из индекса картинки, вместо html подставляем нужный формат: jpg, png и т.д. Точно так же можно запретить индексацию и любых других файлов, просто прописав их формат в первой строчке. Например, doc, txt, pdf, xml и т.д.

Закрытие сайта от индексации через тег metaname=”robots”

Этот метатег прописывается в html-коде страницы в разделе head. Часто он используется, чтобы запретить роботам просматривать часть контента на странице. Например, в каждой товарной карточке у вас есть одна и та же информация про доставку и способы оплаты. Чтобы такое дублирование не влияло на уникальность контента, этот текст можно просто скрыть от поиска.

Этот способ исключения из индекса Google называет предпочтительным. В их инструкции написано, что используя метатег, вы можете быть точно уверены, что контент не будет доступен поисковым роботам. В этом случае не станет препятствием даже то, что на страницу могут ссылаться другие ресурсы.

Важно, что способ работает только для html-файлов. Картинки, папки или файлы других форматов с его помощью не скроешь.

Вот как выглядит код для того, чтобы запретить индексировать весь контент:

<meta name=”robots” content=”noindex, nofollow”/>

или

<meta name=”robots” content=”none”/>

Если вместо “robots” вы используете googlebot или yandex, то сможете запретить индексирование только для одного поискового робота.

Если вы хотите скрыть часть текста, нужен такой код:

<noindex>ваш текст</noindex>

Закрыть ссылку можно, добавив такую строчку:

<a href="url" rel="nofollow">текст ссылки</a>

Вот что означают сами теги:

- noindex — запрет индексации всей страницы или какого-то текста;

- nofollow — запрет на переход по ссылкам на странице;

- none — означает, что на странице нельзя ни индексировать её текст, ни переходить по ссылкам. Заменяет сразу два предыдущих тега.

Очень важно, что для того, чтобы всё работало корректно, нельзя блокировать доступ сразу и в robots.txt, и с помощью метатега. Если вы уже заблокировали роботам доступ к странице, то они не увидят, есть ли в её коде запрещающий тег. Поэтому если вы думаете, что так сайт точно будет полностью закрыт для поисковых роботов, это не так.

Какой способ выбрать?

Всё зависит от ваших целей и предпочтений. Например:

- Если нужно скрыть весь ресурс, быстрее всего сделать это через robots.txt;

- Если необходимо запретить роботам просматривать часть контента на странице, подойдёт metaname=”robots”;

- Если запрет с помощью robots.txt не сработал, можно использовать htaccess;

- Если не хотите лезть в код, лучше зайти в robots.txt;

Если нужно закрыть файлы разных форматов, можно использовать либо robots, либо htaccess.