Robots.txt — что это такое и как его настроить

Рассказываем про очень важную составляющую индексации сайта — файл robots.txt. Если неправильно его настроить, то ваш сайт просто не попадёт в поисковую выдачу.

-

10+

стаж работы в

интернет маркетинге -

103

написано тематических

статей

Что такое robots.txt? Это файл, который располагается в корневой папке почти любого сайта. Он включает определённые команды, которые указывают поисковым роботам, какую информацию они могут просканировать на вашем сайте, а какую нет. Если такого файла на ресурсе не будет, боты отсканируют всё подряд, и в выдаче могут оказаться личные данные ваших клиентов или другая скрытая информация.

Разбираемся, как правильно подойти к настройке файла. А если он у вас уже есть, посмотрим, как проверить корректно ли он работает.

Зачем всем сайтам нужен robots.txt?

Прежде чем сайт окажется в поисковой выдаче, ему нужно пройти индексацию. Это процесс, во время которого боты обходят ресурс, сканируют его, а потом добавляют информацию о нём в свой каталог, откуда она уже попадает в выдачу. После этого люди смогут найти этот сайт в поисковике. Позиции, на которых конкретные страницы будут находиться в выдаче, зависят от множества факторов, но на саму возможность оказаться в ней влияет именно индексация.

Так вот файл robots.txt как раз и отвечает за управление индексацией сайта в поисковике. В нём прописаны указания для роботов: какие данные они могут сканировать и потом предлагать пользователям, а какие нет. С помощью robots.txt сайт в принципе можно закрыть от индексации, если вы не хотите, чтобы ссылки на него были в поиске. Например, это может понадобиться, если прямо сейчас на ресурсе происходят какие-то технические работы. В файл вы можете вносить правки в любое время, когда у вас появится потребность открыть или закрыть что-то.

Наличие robots.txt очень важно, ведь на каждом ресурсе есть информация, которая не должна оказаться в общем доступе. Например, платёжные данные или личная информация клиентов. Подробнее о том, что ещё важно скрыть от роботов, поговорим дальше.

А вот для чего ещё нужен robots.txt:

- Снизить нагрузку на сервер. Ведь вы запрещаете сканировать второстепенную для пользователей информацию, которой может быть довольно много. Следовательно, нагрузка заметно снижается.

- Указать ботам путь к карте сайта. Это служебная страница, где перечислены все страницы и разделы ресурса. Она также помогает роботам быстрее и качественнее проводить сканирование. Если добавить карту в robots.txt, поисковые боты быстрее её обнаружат.

Важно знать, что иногда роботы могут проигнорировать директивы запрета, которые есть в файле. Например, Google в своём руководстве пишет о том, что если на скрытую страницу есть ссылки с других страниц или ресурсов, то роботы всё равно могут её проиндексировать. В этой статье мы рассказывали про другие способы закрыть сайт от индексации, которые могут помочь в таких случаях.

Создаём и настраиваем команды в robots.txt

Robots.txt — это текстовый файл. А значит для его создания подойдёт любой текстовый редактор. Например, обычный Блокнот или Word. Из названия файла понятно, что он должен быть сохранён в формате txt, и назвать его нужно “robots”.

После того как файл будет готов, его нужно разместить в корневой папке сайта. Её можно найти на хостинге. В результате у вас должна появиться ссылка на файл такого формата: вашсайт.рф/robots.txt.

А теперь давайте посмотрим, что должно находиться внутри этого файла. Начнём с основных директив, которые используются в документе.

User-agent

Это обращение к поисковым ботам. Такая директива всегда должна находиться в начале файла, потому что иначе непонятно, кому предназначены дальнейшие инструкции. Если после директивы стоит звёздочка, это означает обращение ко всем роботам. Если название конкретного бота, то обращаются только к нему. Самые популярные боты — Yandex и Googlebot. Но также на ресурс могут заходить и другие поисковики (Mail.Ru, Bingbot) или более специфичные боты Яндекса и Google (YandexMetrika, Googlebot-Video)

Вот как может выглядеть такая директива:

User-agent: Yandex

Disallow

Запрещающая директива, которая используется, чтобы показать, какие страницы, файлы, папки или целые разделы должны быть скрыты от индексации. При этом действует принцип “всё, что не запрещено — разрешено”. Поэтому к использованию директивы стоит подойти ответственно и точно прописать в ней всё, что должно быть скрыто.

Как именно закрывать элементы сайта от индексации? Так как домен у всех страниц одинаковый, после названия директивы и двоеточия нам нужно указать только оставшуюся часть адреса. При этом каждый URL не нужно прописывать отдельно. Например, если нам нужно закрыть от индексации разные результаты поиска в форматах:

/search/?q=купить+коньки

/search/?q=чайник+серебряный

/search/?q=елочная+игрушка,

мы возьмём только общую их часть “search”. Тогда директива будет выглядеть так:

Disallow: /search/

Но предварительно стоит проверить, нет ли в этом разделе какой-то важной информации, которая обязательно должна оказаться в поиске.

Allow

Это разрешающая директива. Но мы помним про правило “всё, что не запрещено — разрешено”. Тогда для чего же нужна команда allow? Она помогает добавить исключения из правил. Например, вы хотите запретить индексацию всем, кроме Google. Тогда с помощью disallow мы закрываем индексацию для всех, а потом добавляем allow, где обращаемся только к роботам Google.

Пример:

Disallow: /

User-agent: Googlebot

Allow: /

Sitemap

Эта команда показывает ботам путь, по которому находится карта сайта. Нужна она в первую очередь для того, чтобы ботам было проще ориентироваться на ресурсе. Без этого какие-то страницы могут не попасть в индекс, а сама индексация займёт больше времени. Логично, что всё, что вы закроете в robots.txt нет смысла добавлять и в карту сайта.

Ссылку на карту нужно указывать, чтобы поисковым ботам было проще её найти. Ведь первое, на что они обращают внимание при сканировании сайта, как раз файл robots.txt.

Вот как выглядит строка с директивой:

Sitemap: https://site.ru/sitemap.xml

Clean param

Эта директива используется довольно редко, но при этом она довольно полезная. Её задача — сэкономить ваш краулинговый бюджет, не дав роботу несколько раз сканировать одни и те же страницы.

В URL помимо основного адреса страницы могут отображаться разные параметры. Например, уникальный код пользователя, данные рекламной кампании, с которой он пришёл и т.д. Так вот если вы укажете все эти мелочи в clean param, робот поймёт, что они никак не влияют на основное содержание страницы и будет более эффективно подходить к сканированию ресурса.

Crawl-delay

Сразу скажем, что Google эту директиву игнорирует. Но она тоже достаточно полезная. Используется она для того, чтобы немного разгрузить сервер. С её помощью вы можете установить продолжительность интервала между завершением сканирования одной страницы и началом сканирования другой. Ведь если бот будет сразу анализировать всё подряд, это может привести к неполадкам в работе системы. Измеряется эта пауза в секундах. Обратите внимание, что сразу большой интервал (например, 2 секунды) задавать не стоит. Лучше начать с минимальных (например, 0,1 секунда), а потом постепенно повышать показатели. При этом для роботов, которые посещают вас редко и не так важны для продвижения, задержку можно установить больше, чем для Яндекса.

Host

Это директива, которая отвечает за то, чтобы сообщить роботам адрес главного зеркала сайта. Но сейчас эта команда уже устарела, и её перестали использовать. Вместо этого на всех неосновных версиях теперь нужно прописывать 301 редирект.

Также в документе можно использовать несколько дополнительных символов:

- Решётка #. С её помощью можно оставлять комментарии к директивам. Робот такие пометки не прочитает, но зато их поймут люди, которые в будущем будут работать с файлом. Например, через какое-то время вы можете не вспомнить, почему закрывали от ботов ту или иную страницу. Или вы найдёте нового SEO-специалиста, которого нужно будет погрузить в контекст. С такими пометками это будет сделать гораздо проще.

-

Звёздочка *. Означает, что после неё может идти любая последовательность знаков. В каждой строке её можно не проставлять, потому что по умолчанию и так подразумевается, что команда распространяется на все URL, входящие в папку или раздел. Символ можно использовать для более тонких настроек. Например, если у вас на ресурсе есть функция поиска в разных разделах, директива для того, чтобы закрыть все результаты, может выглядеть так:

Disallow: /*/search/

-

Доллар $. Используется, чтобы обозначить конец строки. То есть все символы, которые будут находиться после $, не будут попадать под правило. Например, если мы напишем директиву:

Disallow: /image/,

то она запретит индексирование всех страниц в этом разделе. А если закрыть её с помощью доллара:

Disallow: /image$,то под запрет не попадут адреса вроде /image1 или /images.

Какую информацию важно скрыть?

- Страницы, которые ещё не готовы. Если у вас есть страницы, которые сейчас находятся в процессе разработки, лучше скройте их до тех пор, пока они не будут полностью готовы. То же самое и с целым сайтом. Если он ещё не готов, он не должен оказаться в выдаче. Ведь если половина функций не будет корректно работать, это может испортить репутацию компании, а ещё плохо повлияет на поведенческие факторы. Ведь люди могут просто открывать страницу и быстро закрывать её, когда увидят, что ничего не работает.

- Страницы для печати. Это отдельная версия страницы, которая упрощает её контент для печати. Понятно, что информация там одна и та же, поэтому дублировать её в выдаче не стоит.

- Технические страницы. Например, сюда можно отнести страницу авторизации. Такие данные нужны только для сотрудников компании, а не для всех пользователей.

- Персональные клиентские данные. Это могут быть не только имя и номер телефона, но и платёжные данные. Думаем, не стоит объяснять, почему всё это не должно оказаться в открытом доступе.

- Страницы сортировки. Они содержат практически одинаковый контент, а поисковые системы не любят, когда в выдаче находится повторяющаяся информация. Из-за этого репутация сайта может падать.

А что делать со страницами пагинации? Так называют большие массивы данных, которые разделяют на отдельные страницы, чтобы пользователю не пришлось слишком долго проматывать контент вниз. Чаще всего такой формат встречается в каталогах интернет-магазинов. Мы не рекомендуем закрывать страницы пагинации в robots.txt. Лучше решить проблему с помощью тега canonical. Им можно обозначить основную страницу. Тогда поисковая система не будет рассматривать такой контент, как дублирующий.

Почему всё, что мы обсудили выше, стоит закрыть от индексации?

- Какая-то информация просто не должна стать доступна большому количеству людей. Например, пароли и личные данные.

- Какой-то контент не несёт никакой пользы для людей. В этом случае пострадают поведенческие факторы, ведь даже если люди зайдут на ресурс, они будут очень быстро с него уходить.

- Впустую тратится краулинговый бюджет. Это определённое количество страниц, которое роботы могут отсканировать за один раз, и периодичность, с которой они это делают. Краулинговый бюджет различается для каждого отдельного сайта. Если он будет потрачен на бесполезные страницы, то до реально полезного контента дело может так и не дойти.

- Система не любит дублирующий контент. Из-за этого может страдать авторитетность ресурса.

Частые ошибки, которые допускают при создании robots.txt

- Объединение нескольких элементов в одну директиву. Если вам нужно скрыть из поиска несколько разделов, каждый из них должен быть прописан с новой строки.

- Разный регистр символов. Следите за тем, чтобы в ваших директивах был прописан правильный регистр. Если некоторые боты могут проигнорировать такую опечатку, другие из-за этого не смогут распознать важную команду.

- Точка или точка с запятой в конце строки. Закрытие строки не нужно никак дополнительно помечать. Наоборот, это может помешать читать их.

- Неправильное название файла. Он может называться только robots.txt и никак иначе. Обратите внимание на нижний регистр и отсутствие лишних символов. В противном случае боты просто не смогут его распознать.

- Наличие символов на кириллице. В robots.txt можно использовать только латинские символы, иначе боты вас не поймут. Это касается всех директив, кроме комментариев, сопровождаемых знаком #. Если домен вашего сайта на русском языке, его URL придётся дополнительно преобразовывать с помощью кодировки Punycode. Для этого существуют онлайн-конвертеры.

- Слишком большой размер файла. Его вес не должен быть больше 32 Кб. Иначе боты опять же не смогут его прочитать. Поэтому следите за размером и удаляйте всё, что стало неактуальным.

- Команды вроде “Disallow: Yandex”. Правило всегда одно: сначала обращаемся к роботу с помощью user-agent, а уже потом просим его выполнить то, что нам нужно.

- Перечисление каждого отдельного файла в папке. Если вы закрываете какую-то папку, то к индексации будут запрещены и все файлы, находящиеся внутри неё. Поэтому их не нужно прописывать отдельно.

- Отсутствие проверки корректности работы. Даже если вы несколько раз перечитали все команды в своём robots.txt, не помешает проверить его автоматическими сервисами. Ведь иногда глаз замыливается, и ошибки перестаёшь замечать. О том, какими способами можно проверить файл, мы расскажем в конце статьи.

Другие способы создания robots.txt

Способ, который мы разобрали выше, можно назвать ручным. Ведь в нём мы сами создаём документ и прописываем в нём все нужные нам запреты и разрешения. Но есть и другие более автоматизированные способы.

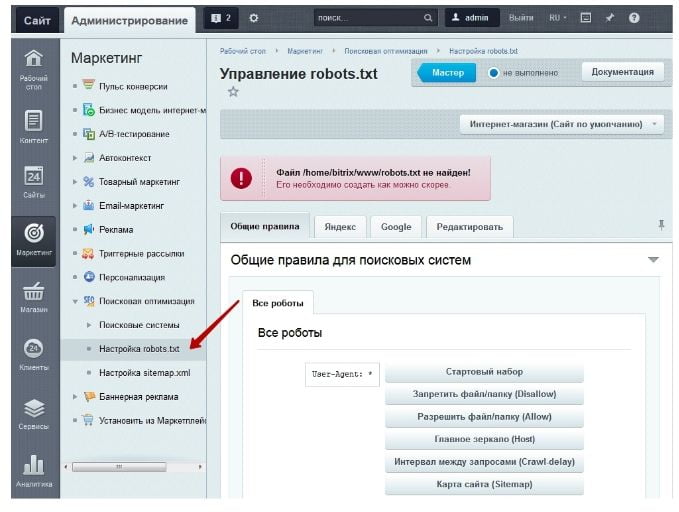

Инструменты CMS

Если ваш сайт сделан на CMS, создать robots.txt можно с помощью встроенных инструментов в админ-панели или добавленных плагинов. Например, для сайтов на Wordpress есть плагин Virtual Robots.txt. А в модуле поисковой оптимизации Битрикс, начиная с 14 версии, есть встроенный инструмент для работы с файлом. Находится он по пути Маркетинг — Поисковая оптимизация — Настройка robots.txt.

Tilda обещает полностью автоматически сгенерировать за вас файл. Найти его можно по обычному адресу: вашсайт.рф/robots.txt. Вносить корректировки в сам файл нельзя, но в настройках каждой страницы можно отдельно запретить её индексирование поисковыми системами.

Онлайн-генераторы

Также существуют простые онлайн-сервисы, которые помогут быстро сформировать для вас готовый файл. Конечно, они не смогут учесть тонкие материи в виде отдельных исключений для каких-то роботов или файлов из скрытых разделов, но для простых команд такие сервисы вполне подойдут.

Обычно в них достаточно указать домен сайта, отметить ботов, для которых вы хотите запретить индексацию, и прописать адреса нужных разделов, страниц или файлов. Также иногда туда можно добавить ссылку на карту сайта и указать значение директивы crawl-delay. Вот несколько примеров таких онлайн-генераторов: CY-PR, SAS, Daruse. В целом все они практически одинаковые, поэтому такой сервис можно просто найти в поисковике.

Как убедиться, что всё работает правильно?

Проверить, правильный ли файл robots.txt вы создали, можно в сервисах от поисковых систем.

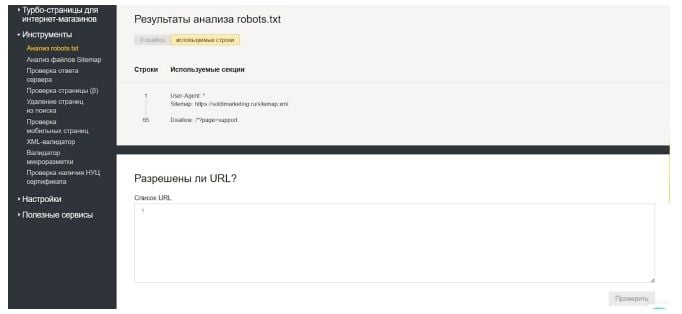

Яндекс.Вебмастер

В левой колонке найдите раздел “Инструменты”. В нём кликните по “Анализ robots.txt”. Вам нужно указать, на какой сайт вы собираетесь добавить файл, а потом вставить текст его содержимого в поле ниже. После проверки сервис может сказать о том, что всё хорошо, либо выдать ошибки и предупреждения. Ошибки — более серьёзная вещь. Из-за них может быть необработана какая-то строка, а может не читаться даже весь документ. Предупреждения указывают на то, что вы немного отклонились от правил или сделали опечатку. И ошибки, и предупреждения желательно исправить.

В Вебмастере, в отличие от сервиса Google, можно проверить правильность любого файла, а необязательно того, который находится на ресурсе, куда у вас есть доступ администратора. Но если вы подтвердили права на владение сайтом, то можете настроить уведомления о любых ошибках и предупреждениях, которые могут в будущем возникать в файле, если вы его отредактируете. Это поможет лучше контролировать ситуацию.

Также в этом же инструменте можно проверить, разрешено ли индексирование конкретных URL. Их можно загрузить в соответствующее поле списком.

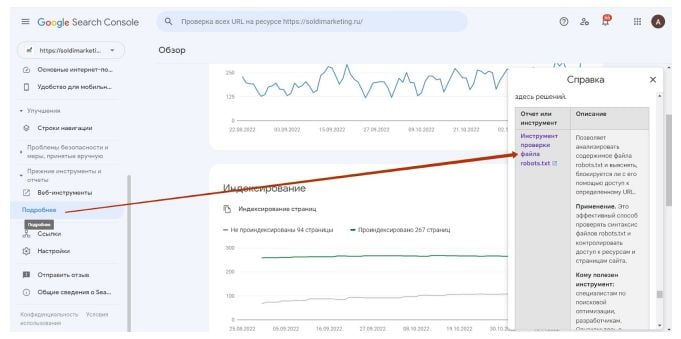

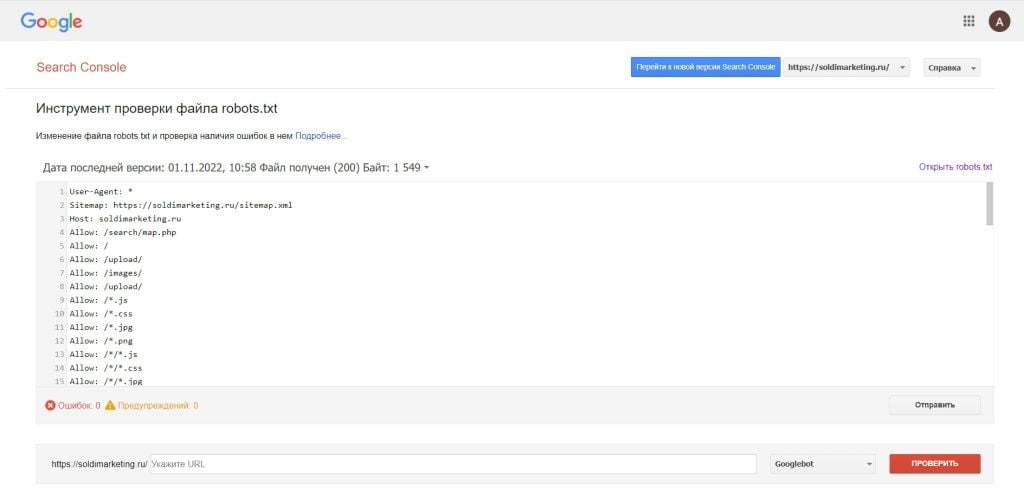

Google Search Console

В левом столбце нужно нажать на раздел “Подробнее”, а потом в справке зайти в “Инструмент проверки файла robots.txt”. Доступ сюда у вас будет только если сайт добавлен в Search Console, и у вас подтверждены права на него.

В поле копируем текст из нашего документа, а ниже указываем адрес сайта и нажимаем “Проверить”. Если в директивах есть ошибки, система покажет их в результатах.

Ещё несколько полезных советов

Если правила сканирования у вас различаются для разных поисковиков, объедините их в группы. Блоки можно отделить пустыми строками. Так каждому боту понадобится меньше времени на то, чтобы найти информацию, предназначенную именно ему.

- Обязательно откройте для индексации стили css и js. Без этого боты не смогут увидеть страницы так, как их видит живой человек. Поэтому они могут сделать вывод, что ресурс не адаптирован под мобильные. Также если какая-то часть контента подгружается с помощью js, то боты просто её не увидят. Это может плохо повлиять на ранжирование сайта, потому что в таком случае контент может выглядеть бесполезным и некачественным. Поэтому рекомендуем добавить в ваш robots такие директивы: Allow: /*.js Allow: /*.css

- Не добавляйте на свой сайт первый попавшийся в интернете robots.txt, который вроде бы вам подходит. Это серьёзный инструмент, который может полностью лишить вас поискового трафика, поэтому если вы не уверены в том, что разбираетесь в работе директив, лучше посоветоваться с профессионалами.