Индексация сайта: что это за процесс и как его ускорить

-

10+

стаж работы в

интернет маркетинге -

103

написано тематических

статей

Индексация сайта — важный процесс, без которого ресурс просто не будет виден пользователям в поисковой выдаче. Это ещё не ранжирование, когда система определяет на какое место поставить сайт. Это предыдущий этап, когда ресурс просто добавляется в гигантский каталог поисковой системы, откуда уже может попасть в выдачу. То есть без индексации нет смысла ни в никаком SEO-продвижении: ведь, чтобы говорить о раскрутке ресурса, надо сначала оказаться в выдаче.

В статье поговорим о том, как технически происходит индексация, есть ли отличия в процессах Яндекса и Google и как ускорить момент появления сайта в поисковиках.

Что такое индексация сайта в поисковых системах?

Индексация — это процесс сканирования сайта поисковыми роботами и добавление данных о нём в систему. Ресурс станет доступен пользователям в поисковиках только после того, как первая индексация будет завершена. То есть в поисковую выдачу попадают не все существующие сайты, а только те, что разрешили индексацию своего ресурса. Правда иногда она может быть доступна по умолчанию.

Индексация нужна не только затем, чтобы сайт попал в поисковую выдачу. Она ещё и облегчает жизнь поисковикам. Ведь если все ресурсы проиндексированы, не нужно каждый раз тратить много времени на анализ ресурсов, чтобы выдать максимально релевантный ответ на запрос пользователя. В индексе все страницы рассортированы по тематикам в зависимости от содержания их контента. Конечно, поисковые системы ещё не научились “читать” тексты, но анализировать смысл некоторых слов и в зависимости от этого определять тематику они умеют.

Всю эту систему можно представить в виде библиотеки: роботы просто смотрят каталог, находят там нужные издания, а потом быстро выдают их пользователям в выдаче. При этом по одному и тому же запросу выдача для каждого человека может быть индивидуальной. Всё зависит от местоположения, устройства, с которого он вышел в интернет, истории поиска и других факторов. Весь этот анализ происходит очень быстро, поэтому пользователь даже не замечает всей внутренней работы.

Индексация — это процесс, который повторяется не один раз. Поисковые роботы периодически заново обходят все сайты, которые есть в базе. Ведь на них могли появиться новые страницы или контент на старых мог просто обновиться. Также это защита от нарушений со стороны вебмастеров. Если ресурс один раз попал в индекс это не значит, что через определённое время он не заменит свой контент на запрещённый или не начнёт обманывать пользователей. Поэтому через индексацию регулярно проходят даже те страницы, которые уже давно есть в выдаче.

По результатам индексирования сайт необязательно попадает в базу поисковика. Иногда на него, наоборот, могут наложить санкции, и тогда он перестанет появляться в поиске, даже если до этого там был. Например, такое может произойти, если контент на странице заспамленный, неуникальный или не даёт людям никакой пользы.

Как происходит процесс индексации?

У поисковых систем есть специальные роботы, их ещё называют краулеры или пауки. Вот как они выполняют свою работу:

- Для начала им важно зайти в файл robots.txt. В нём содержится вся информация о том, какой контент можно сканировать, а какой нельзя. Также там можно в целом закрыть от индексирования весь сайт. Если такого файла нет, роботы будут анализировать всю информацию целиком.

- Если ресурс всё-таки открыт, робот может зайти на него и просканировать значимые для него страницы, служебные данные и информацию о сервере. Этим занимается так называемый быстрый робот, который также ставит ресурс в очередь на обход основным роботом.

- Основной робот проходится по всем страницам и анализирует данные: собирает весь контент, вычленяет главное, очищает его от ненужной информации. Оцениваются не только тексты, но и видео, картинки, аудиофайлы, метатеги, ссылки и т.д.

- После этого контент проверяется на соответствие основным критериям качества: уникальности, незаспамленности, полезности и т.д.

- Если на предыдущем этапе никаких проблем не выявили, вся собранная информация упорядочивается и разносится по отдельным тематикам в каталоге. Спустя некоторое время проиндексированные материалы можно будет увидеть в выдаче.

На каждый сайт поисковая система выделяет свой краулинговый бюджет. Он определяет количество страниц, которые она может проверить за одно посещение, и частоту таких посещений. От чего зависит этот бюджет никто точно не знает, но есть предположения, что от возраста ресурса, частоты обновления контента на нём и посещаемости.

Например, логично, что для новостных ресурсов, которые каждый день публикуют много контента, этот бюджет должен быть больше. В итоге роботы посещают такие ресурсы аж несколько раз в день, потому что в противном случае новости успеют состариться пока робот до них дойдёт. Что касается количества, за один раз роботы в среднем проверяют примерно 20-30 страниц. Поэтому если ресурс большой, полного его индексирования можно ждать довольно долго.

У разных поисковиков существуют небольшие отличия в процессе индексирования. Точных алгоритмов никто не знает, но кое-что специалистам всё-таки известно.

Различия технологий индексации в Яндексе и Google

В этой поисковой системе давно существует фильтр Mobile first. Это означает, что сайтам с мобильной версией при ранжировании всегда отдаётся предпочтение. То есть, если ресурс не адаптирован под мобильные, он точно не сможет попасть в топ выдачи. Это накладывает свой отпечаток и на индексацию. Когда роботы анализируют ресурс, в индексе сохраняется именно версия для мобайла. Если она некачественная и недостаточно информативная, сайт не сможет оказаться в индексе. Поэтому мобильной версии стоит уделить так же много внимания, как и основной.

Также у Google точно есть краулинговый бюджет: компания официально признаёт его существование. Следовательно, мы точно знаем, что на некоторые ресурсы роботы заглядывают чаще и за один раз индексируют больше.

В целом Google обычно быстрее индексирует сайты. Вы можете сегодня добавить на свой ресурс новую страницу, а уже через пару дней она появится в поиске.

Яндекс

При сканировании ресурса Яндекс не уделяет такого внимания мобильной версии: он больше ориентируется на десктопную. Поэтому при внедрении алгоритма Mobile first у многих сайтов показатели в Google просели, а в Яндексе остались такими же.

Сроки индексирования у Яндекса часто больше: обычно он заходит на ресурс несколько раз в месяц, поэтому появления вашего нового контента в выдаче придётся подождать. Но если сайт крупный, авторитетный и посещаемый, роботы будут заглядывать к нему чаще, чем к другим. При этом официальной информации о наличии в Яндексе краулингового бюджета нет.

Для корректной индексации в своих руководствах Яндекс рекомендует:

- Не использовать слишком длинные URL и большое количество cgi-параметров;

- Не использовать документы размером больше 10 Мб (они не проиндексируются);

- В PDF-файлах не размещать текст в виде картинок (он тоже не проиндексируется);

- Выносить мобильные версии на отдельные поддомены. Это же относится и к версиям на разных языках.

Как настроить индексацию?

В целом специально предпринимать какие-то действия для того, чтобы сайт проиндексировался не нужно. Мы уже говорили, что если у вас нет файла robots.txt, то сканирование всей информации с сайта по умолчанию разрешено. Но если вы всё-таки не хотите выводить в выдачу все свои данные, стоит поработать с файлом robots.txt, потому что в вопросе индексации это один из самых важных моментов.

Если файл есть, для начала проверьте, что сайт в целом доступен для сканирования поисковым роботам. Если это не так, в файле вы увидите вот такие директивы:

User-agent: *

Disallow: /

После этого можно посмотреть, какой именно контент доступен, а какой закрыт от индексации. Обычно закрывают:

- Пользовательские данные;

- Корзину, страницу оформления заказа, личные кабинеты, список избранных товаров;

- Страницы с применёнными фильтрами, сравнением цен или характеристик, результаты поиска по сайту. Они дублируют контент, из-за чего поисковая система считает их некачественными, а это может повлиять на авторитетность ресурса;

- Версии для печати и т.д.

Если закрыт оказался контент, который должен быть в выдаче, обязательно поправьте это.

Если файла robots.txt у вас нет, создайте документ в соответствующем формате, добавьте его в корневую папку сайта и поработайте с его наполнением.

Для работы с файлом существуют две основные директивы: allow (разрешено) и disallow (запрещено). То есть, если мы видим такой код:

User-agent: *

Disallow: /search/

это значит, что всем поисковым роботам нельзя сканировать и индексировать любые URL формата https://site.ru/search/, какое бы продолжение у них ни было.

Здесь работает формат “всё, что не запрещено — разрешено”. Поэтому директива allow используется в качестве слова “кроме”. Пример:

User-agent: *

Disallow: /

User-agent: Yandex

Allow:/

Такой код будет читаться так: сканирование запрещено всем роботам, кроме роботов Яндекса.

Как ускорить индексацию страниц сайта?

Иногда роботам требуется довольно много времени, чтобы добраться до конкретной страницы, которую вы считаете важной. Или они вообще могут её пропустить. Поэтому роботам можно немного помочь. Вот несколько способов это сделать:

Карта сайта

Ускорить попадание в индекс поможет карта сайта (sitemap). Это специальная страница, где содержится список страниц и разделов ресурса. Такие карты бывают двух видов: в формате HTML и XML.

HTML-страница больше предназначена для пользователей. С её помощью они могут быстро посмотреть на устройство ресурса и переместиться в нужный раздел. У такой карты нет цели представить все до единой страницы. На ней обозначаются только основные разделы и подразделы, поэтому индексации она никак не поможет.

Карта в формате XML-файла более объёмная и содержит полный список страниц сайта. Работает она буквально как обычная карта: такой список даёт поисковым роботам возможность свободнее ориентироваться в структуре ресурса. За счёт этого они ничего не упустят и быстрее проиндексируют ресурс. Ведь с картой по незнакомой местности двигаться всегда проще, чем без неё. Также в такой карте можно указать приоритетность страниц и даты обновления контента на них, чтобы роботы понимали, что стоит отсканировать и проиндексировать в первую очередь.

Вебмастерские

У сервисов для вебмастеров от поисковых систем есть свои инструменты, которые тоже помогают ускорить попадание в индекс. В Яндексе этот инструмент есть в Вебмастере, а в Google в Search Console.

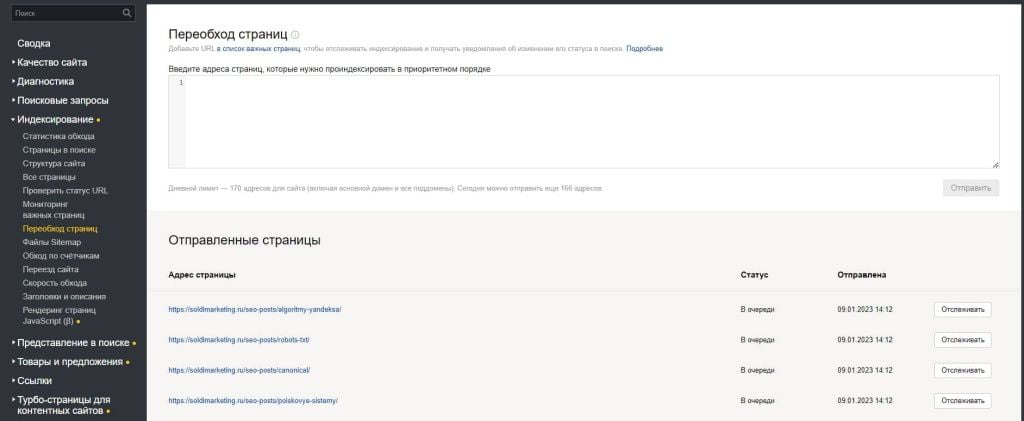

- Яндекс.Вебмастер

Чтобы запросить индексацию, нужно зайти в раздел “Индексирование”, а потом на “Переобход страниц”. В специальном поле можно указать список URL, которые вы просите робота посетить в первую очередь. Это не значит, что после этого они уже на следующий появятся в индексе. Просто в следующий раз, когда робот заглянет на ваш ресурс, эти страницы он отсканирует в приоритетном порядке.

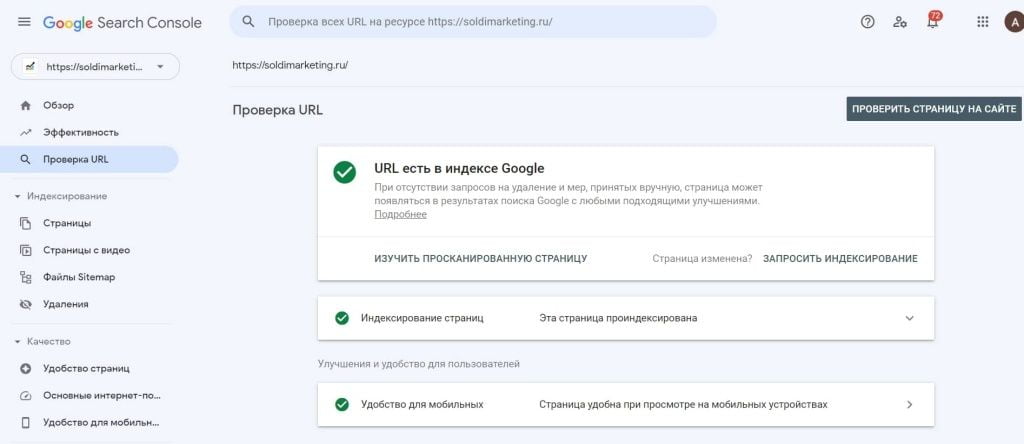

- Google Search Console

В Search Console есть инструмент проверки URL. Он тоже даёт возможность попросить роботов посетить конкретную страницу. Обычно процедура занимает около одного дня, но в некоторых ситуациях система может проверять материалы до двух недель. Важно, что отправка запроса не гарантирует того, что страница обязательно попадёт в индекс. Если система обнаружит на ней какие-то нарушения, то вполне может отклонить ваш запрос.

На отправку URL есть дневные лимиты. Поэтому если вам нужно отправить на индексацию много страниц, Google рекомендует добавить их в карту сайта, пометить тегом <lastmod>, указать дату обновления контента и загрузить файл в Search Console.

Сам инструмент для проверки находится в верхней части левой колонки. Вот как им пользоваться:

- Введите ссылку на нужную страницу в строку поиска наверху.

- После этого система покажет вам информацию об индексации конкретного URL: он может быть уже добавлен в индекс или отсутствовать там.

- Если страницы ещё нет в индексе, можно отправить её на индексацию. Если есть, можно попросить робота ещё раз проверить её, если информация там обновилась. Для этого нажимаем “Запросить индексирование”.

Внешние ссылки и перелинковка

Ускорить индексацию можно также с помощью внешних ссылок на ваш сайт и грамотной перелинковки внутри ресурса. Google в своём руководстве для вебмастеров пишет, что роботы могут обнаруживать новые URL, когда переходят на них с других уже известных страниц. Так что если у вас новый сайт, постарайтесь получить на него внешние ссылки. О том, где их взять, мы рассказывали в этой статье. Если ресурс уже есть в индексе, но вы добавили на него новые страницы, обязательно сошлитесь на них с других своих уже известных роботам страниц.

Как проверить индексацию?

Если вы не уверены, проиндексирован ли ваш сайт, это можно проверить. Для этого можно использовать:

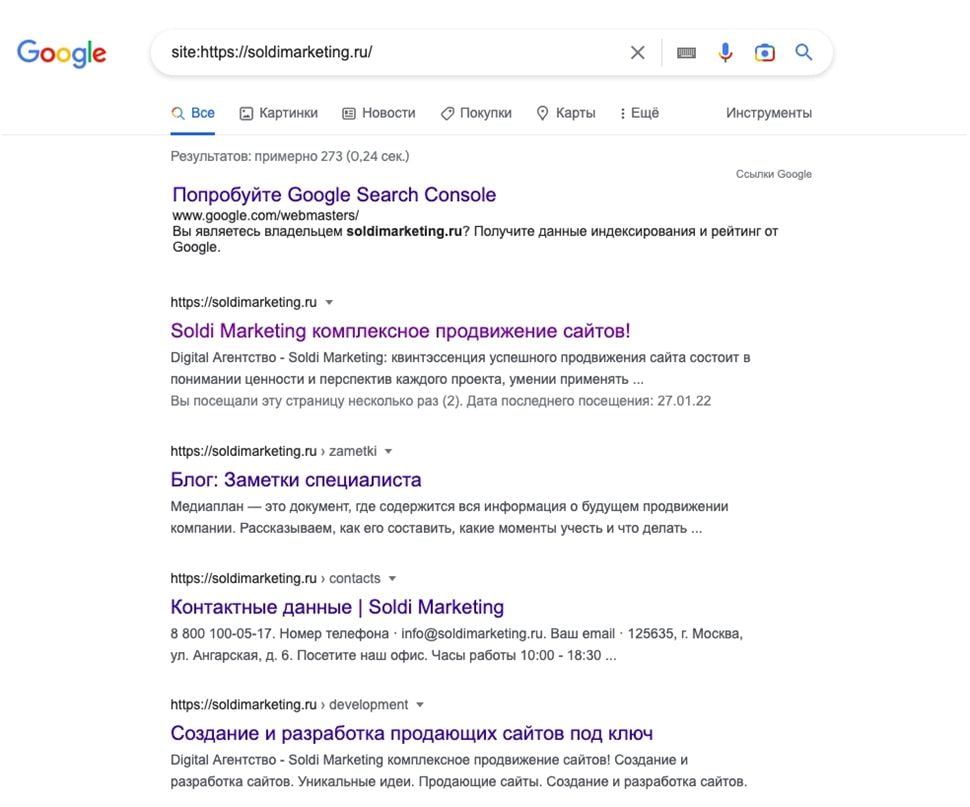

- Специальные операторы. Их нужно вводить в поисковую строку перед ссылкой на ресурс. Например, если ввести в любой поисковик “site: ссылка на сайт” (без кавычек), то в результатах выдачи вы увидите все страницы, которые сейчас есть в индексе. Это число можно сравнить с общим количеством URL и посмотреть, сколько из них не попало в базу поисковых роботов. Ещё один оператор — host. Его точно так же нужно подставить перед ссылкой и отделить двоеточием. Тогда в выдаче появятся проиндексированные результаты с конкретного домена. Это актуально, если у вас есть поддомены для разных городов.

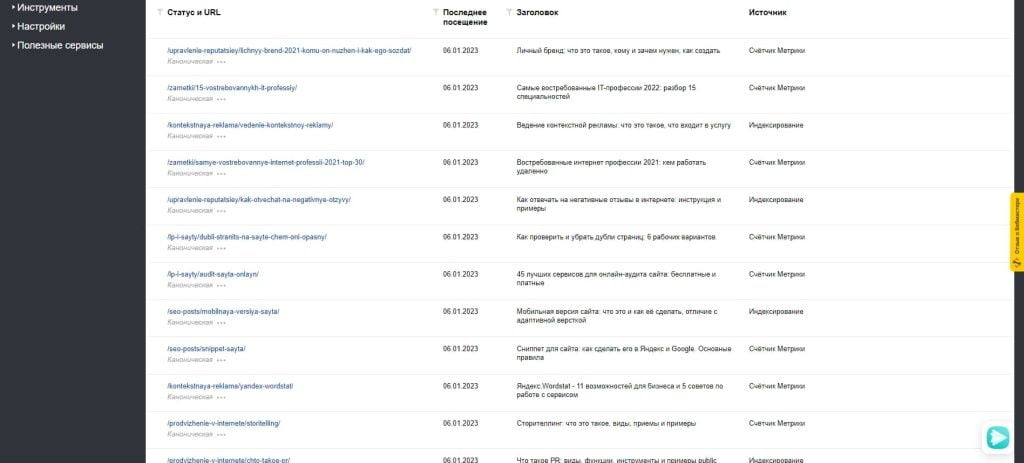

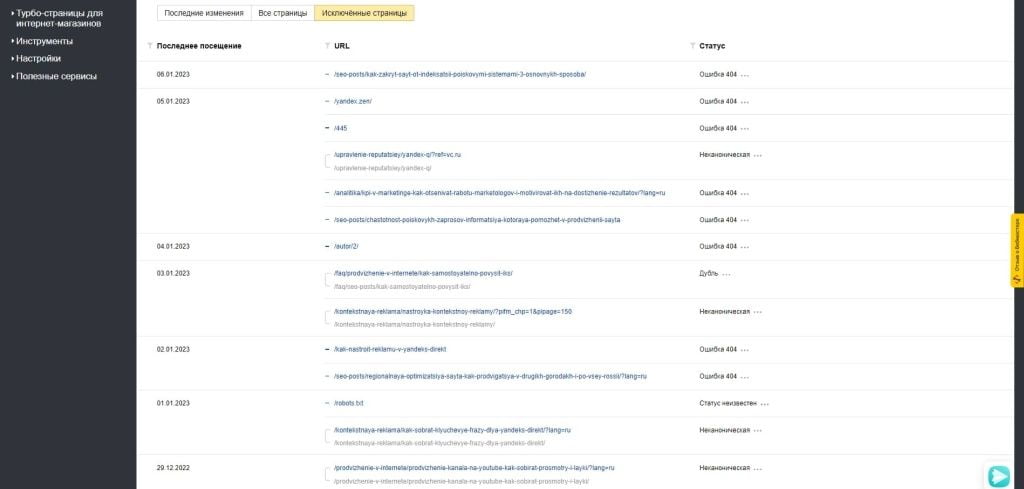

- Яндекс.Вебмастер. Для этого есть специальный блок “Страницы в поиске” в разделе “Индексирование”. Там можно найти все проиндексированные URL и страницы, которые, наоборот, не индексируются в Яндекс.

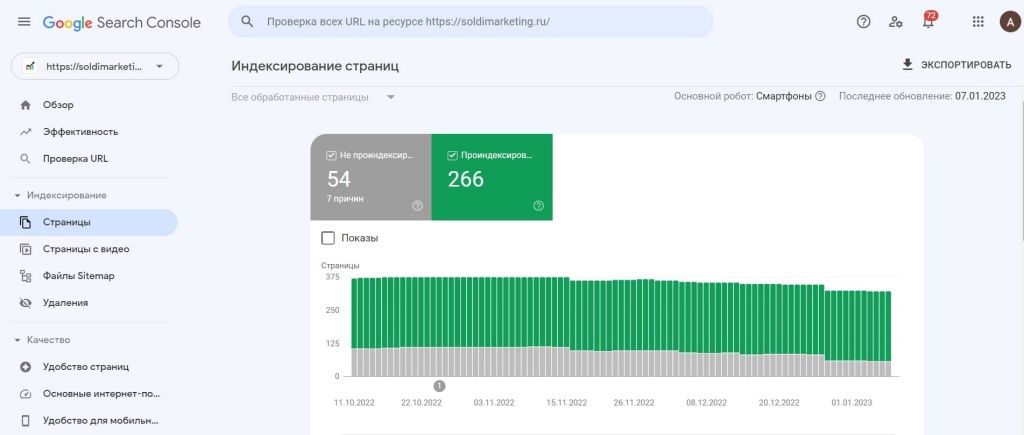

- Google Search Console. Здесь тоже есть статистика по проиндексированным страницам. Находится она в разделе “Индекс” на вкладке “Страницы”. Там есть количество и проиндексированных, и непроиндексированных URL. Также можно воспользоваться инструментом “Проверка URL”, о котором мы говорили выше. Если вам нужно проверить только одну-две страницы, их вполне можно загрузить туда, а система покажет их статус.

Иногда можно заметить, что в разных поисковиках проиндексировано разное количество страниц. Если разница небольшая (около 10%), то в этом нет ничего страшного. Как мы уже говорили, у поисковых систем разные алгоритмы, поэтому небольшие расхождения быть могут. Если разница в количестве существенная, стоит всё-таки узнать причину. Например, это может быть из-за того, что в файле robots.txt вы запретили сканировать сайт только одному конкретному поисковику.

Про проверку индексации у нас есть более подробная статья. Там можно найти ещё несколько других способов.